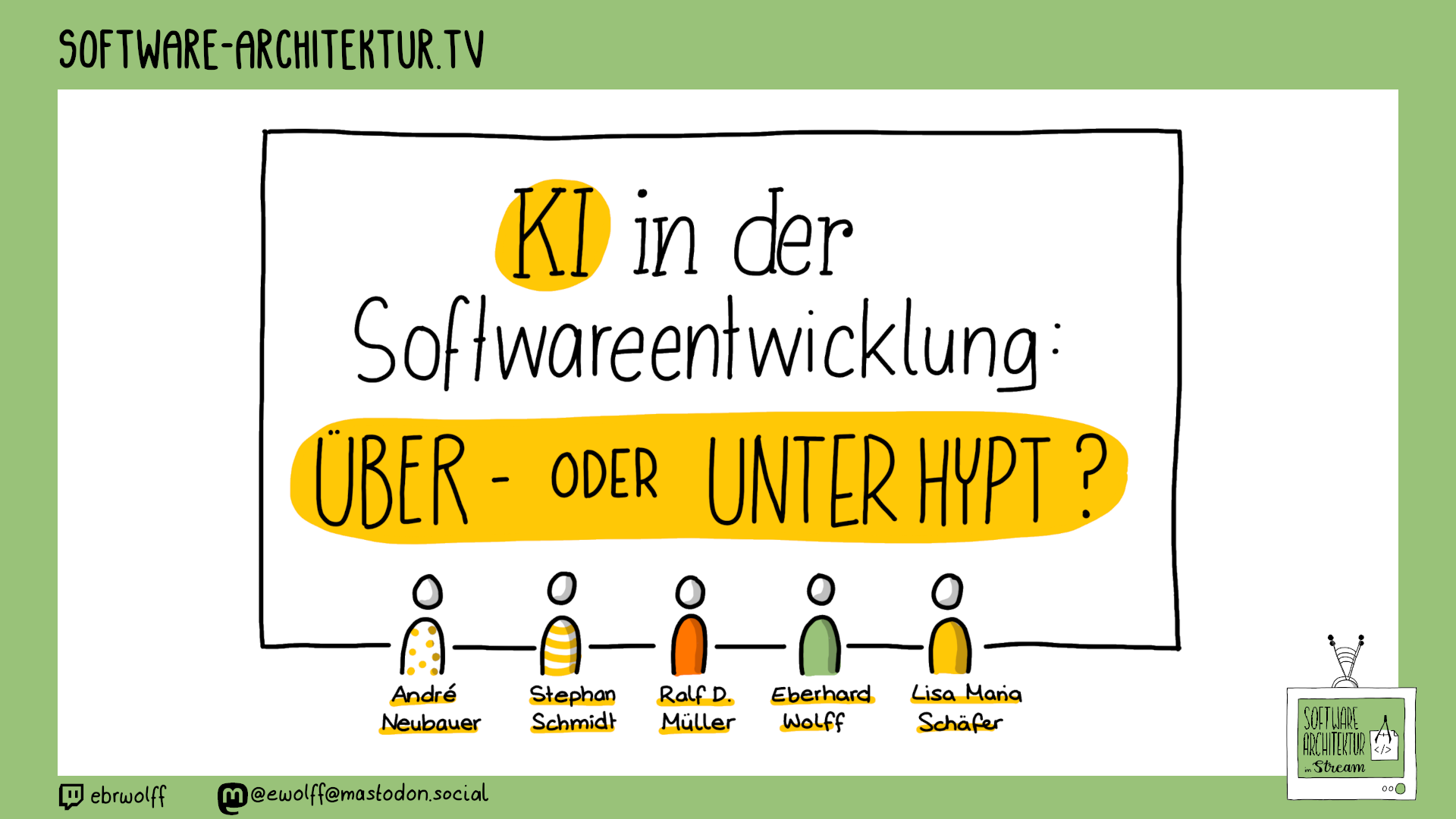

Künstliche Intelligenz (KI) schickt sich an, Software-Entwicklung zu revolutionieren - kein Stein bleibt auf dem anderen, Entwickler:innen werden überflüssig, so die einen. Die anderen sagen: KI hat sicher eine Auswirkung auf Software-Entwicklung, aber die grundlegenden Probleme bleiben dieselben. In dieser Runde moderiert Lisa ein Gespräch zwischen André Neubauer, CTO Trusted Shops, Stephan Schmidt von Inkmi und CTO-Coach sowie Eberhard und Ralf über KI und die Auswirkungen.

Links

- Chat

- Blog: KI in der Softwareentwicklung: Überschätzt

- Blog: Führt KI zu mehr arbeitslosen Entwicklern oder zu mehr Softwareproduktion?

- LinkedIn-Posting

2024-12-20 Thumbnail

PeerTube Video - no Big Tech!

Peertube-Video von tchncs.de eingebettet anzeigen DatenschutzerklärungVideo bei tchncs.de

YouTube Video

YouTube-Video eingebettet anzeigen DatenschutzerklärungVideo bei YouTube

Podcast

Hier findet sich das Audio als Podcast.MP3 Download

Infos und Feeds zum Podcast